2025年7月15日,英伟达CEO黄仁勋公布了一个震惊AI圈的动静:美国当局本日起排除H20芯片对于华发卖禁令,而就于禁令排除后,云工厂科技发布具体测试数据---8卡141GB显存的H20办事器,能流利运行671B参数的满血版非量化DeepSeek-R1模子,推理吞吐量冲破预期。

硬核实测:141GB H20 跑满血版非量化 DeepSeek 机能周全解析

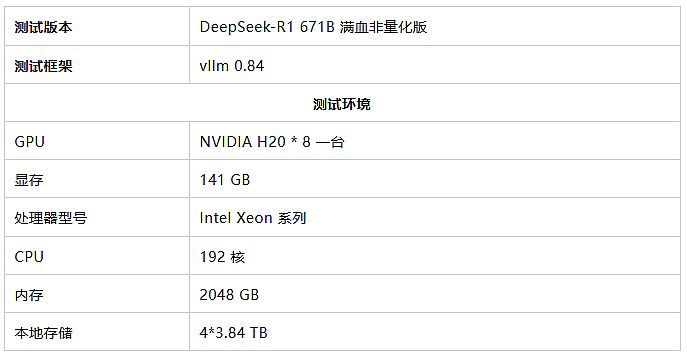

测试情况配置

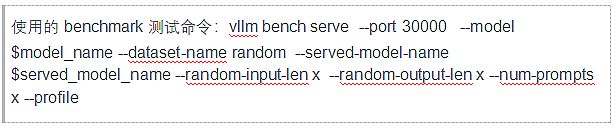

一. 测试数据

二. 要害机能测试成果

测试显示:

1.首token相应快: 于测试的多个并发量下,首个Token的相应时间 (TTFT) 都连结于3秒之内(实测0.1s - 2.8s),用户体验很是流利,觉得不到任何延迟。

2.高并发吞吐年夜:H20显卡揭示出优异的并发处置惩罚能力。于模仿100个用户同时发问(并发哀求=100)的中高负载场景下:

·处置惩罚短问题(输入/输出各256 tokens),体系总吞吐量高达 约1124 tokens/s。

·处置惩罚典型问题(输入/输出各1K tokens),总吞吐量不变于 约1100 tokens/s。

·处置惩罚繁杂问题/长对于话(输入/输出各2K tokens),总吞吐量仍能连结 约1020 tokens/s。

分场景机能趋向:

1.低并发场景 ( 10用户):

·相应极快:TTFT始终低在0.9秒,用户险些觉得不到等候。

·吞吐未饱及: 体系能力远未被充实使用,吞吐量相对于较低(32-208 tokens/s),机能体现轻松自若。

2.中高并发场景 (50-100用户):

·相应依然迅速:TTFT连结于1.9秒 (1K上下文) 到2.8秒 (2K上下文),交互体验依然流利。

·吞吐年夜幅跃升: 体系资源获得高效使用,总吞吐量急剧上升至634 - 1124 tokens/s。

·长上下文上风闪现: 于不异并发下,处置惩罚更长(1K/2K)的上下文凡是能得到比短上下文(256)更高的吞吐量(特别于并发50时最较着),充实表现了vLLM对于长文本的优化效果。

3.极限场景 (100用户 + 长上下文2K):

·相应可控:TTFT为2.8秒,交互体验依然流利。

·吞吐维持高位: 纵然于此压力下,体系总吞吐量仍达1020 tokens/s。

三.测试总结

云工厂科技构建了周全的异构计较资源池,涵盖NVIDIA全系高机能GPU(包括141GB显存H20、L20、RTX 4090等最新型号)、AMD w7900以和国产算力三巨头(华为昇腾910B系列、baidu昆仑芯P800、燧原S60)等等,可当地部署到就近机房,提供DeepSeek、文心一言、华为盘古、LLaMA等开源年夜模子当地部署。

经由过程严酷的横向机能基准测试,云工厂科技验证了差别架构GPU于LLM推理、计较机视觉等场景的能效比差异,并为客户提供"算力租赁 + 算力智能调理 + 平台化交付"的完备 AI 办事系统,今朝已经于教诲/工业/通讯/交通等多范畴乐成落地,支撑其年夜模子部署、推理和场景化落地的全流程需求。

-PT电子